腾讯云计算加速套件TACO KitTACO Infer 概述

背景信息

长期以来,AI 算法用于生产环境大规模模型的推理部署,都存在着多维度的考虑因素:从企业的角度,需考虑如何选择硬件/基础设施来部署业务从而获得最佳投入产出比。例如,如何选择一款加速芯片,满足稳定运行业务模型、业务运行过程中硬件利用率、业务部署是否足够灵活、部署方案的可迁移性等。从系统、测试和运维工程师的角度,面对开发社区算法的快速迭代,需考虑如何以不同框架训练的模型高效且稳定地部署来自上游业务算法,如何整合、利用社区及硬件厂商提供的加速库及软件,对接不同模型、不同硬件,如何将加速软件和自身业务的定制化需求有机结合。而面对不同业务细分场景,需考虑如何标准化一套接口高效地优化和部署业务模型等。TACO Infer 在上述背景下,整合腾讯云及硬件厂商研发资源,面向 AI 负载倾力打造的异构加速引擎。帮助用户快速接入不同硬件,实现通用、易用的优化、加速、部署,避免一款硬件/加速芯片、一套方案的窘境,从而全面提高生产力。

功能介绍

TACO Infer AI 推理加速引擎是一款计算加速推理套件。TACO Infer 从整体设计上看,像是一个大编译器,通过对模型计算图的精细探查,编译最优的执行方案。用户无需自行整合整合利用社区、厂商加速技术,TACO Infer 帮助您简洁、无侵入业务代码地一站式解决 AI 模型在生产环境中应用的问题,方便客户聚焦于自身业务的商业成功。TACO Infer 具备以下功能特点:

简洁部署,无侵入业务代码接入

TACO Infer 仅有一行简洁的优化接口。透明无感接入业务,不改变用户的模型格式,输入的模型格式和输出一致,用户可以保持其一贯的使用和部署习惯。提供插件式的第三方开发接口,支持适配不同业务场景。

软硬件兼容

支持多种框架模型,支持 TenSorflow、PyTorch 已开放支持,ONNX 等框架已在筹备中。兼容 CPU、GPU、NPU 等多种加速硬件。可运行在虚拟机、物理机、容器等各种环境。

集成硬件厂商定向开源的加速方案

厂商加速方案集成。编译优化。图优化和算子优化。

加速效果

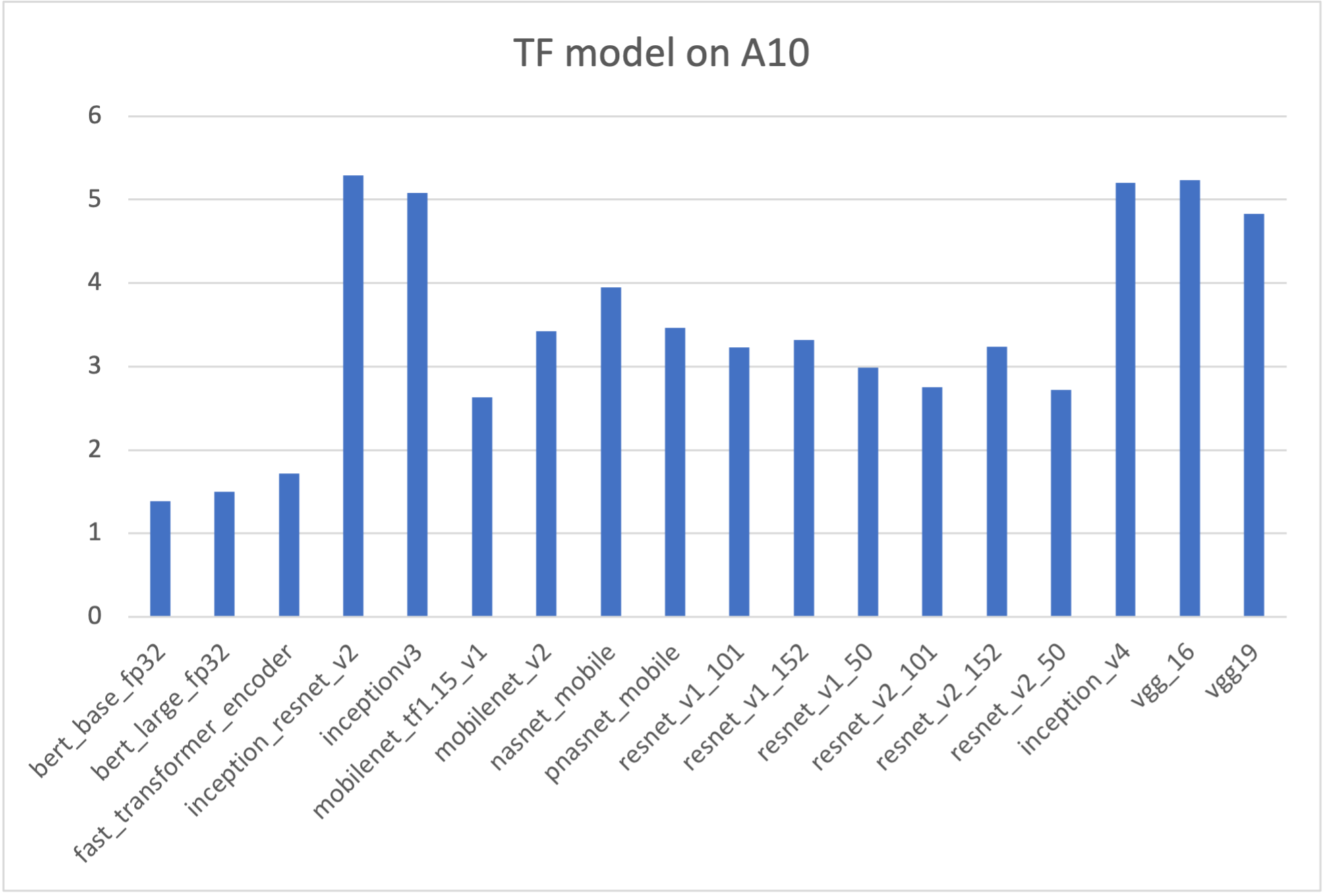

经过 TACO Infer 优化后的模型运行时间与优化前模型运行时间对比,加速效果显著。以下为搭载单卡 NVIDIA A10 的 PNV4 机型 在 batch_size=1 配置下不同深度学习框架的加速比:Tensorflow 2.6

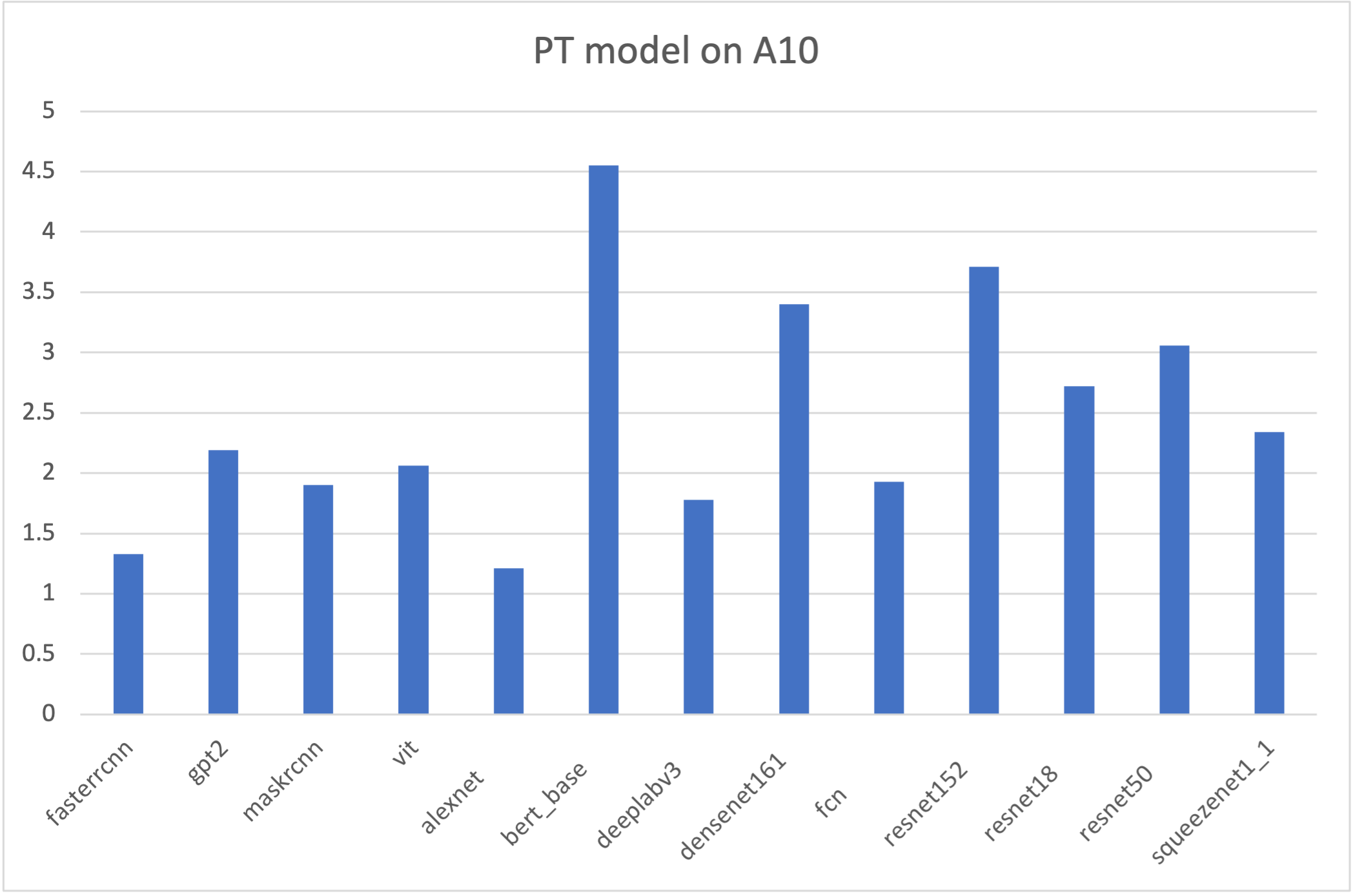

Pytorch 1.12

使用说明

TACO Infer 支持虚拟机、物理机、容器等各种环境,目前已支持 TensorFlow 模型的 CPU 优化部署。TACO Infer 的推理优化部署有以下几个步骤:1. 硬件选型和环境配置n关于计算环境的选型和配置推荐请参见 TACO Infer 使用环境要求,软件安装请参见 安装 TACO Infer 操作步骤。2. 使用 TACO Infer 生成优化模型n您需要使用 Python Wheel 包生成优化的模型,具体操作请参见 TensorFlow 模型优化,优化模型将会存放于您指定的路径,与输入模型保持同一格式,加速效果您可通过 调用优化接口 查看。3. 部署 TACO Infer 优化模型n在完成模型的优化后,您需要将模型部署在生产环境,TACO Infer 提供 SDK 包部署,部署流程请参见 TensorFlow 模型推理部署。按照流程部署编译完成后,运行即可加载优化后的模型进行推理计算。

官网1折活动,限时活动,即将结束,速速收藏

同尘科技为腾讯云授权服务中心。

购买腾讯云产品享受折上折,更有现金返利。同意关联立享优惠

暂无评论,你要说点什么吗?